Product FAQ

Python优化算法01——差分进化算法

参考文档链接:scikit-opt

本章开始Python的优化算法系列。

优化算法,尤其是启发式的仿生智能算法在最近很火,它适用于解决管理学,运筹学,统计学里面的一些优化问题。比如线性规划,整数规划,动态规划,非线性约束规划,甚至是超参数搜索等等方向的问题。

但是一般的优化算法还是matlab里面用的多,Python相关代码较少。博主在参考了很多文章的代码和模块之后,决定学习 scikit-opt? ?这个模块。这个优化算法模块对新手很友好,代码简洁,上手简单。而且代码和官方文档是中国人写的,还有很多案例,学起来就没什么压力...

缺点是包装的算法种类目前还不算多,只有七种:(差分进化算法、遗传算法、粒子群算法、模拟退火算法、蚁群算法、鱼群算法、免疫优化算法)? ? ? /(其实已经够用了)

本次第一节带来的是差分进化算法的使用演示。数学原理就不多说了

首先安装模块,在cmd里面或者anaconda prompt里面输入:

这个包很小,很快就能装好。

差分进化算法

#定义有约束优化问题

'''

min f(x1, x2, x3) = x1^2 + x2^2 + x3^2

s.t.

? ? x1*x2 >= 1

? ? x1*x2 <= 5

? ? x2 + x3 = 1

? ? 0 <= x1, x2, x3 <= 5

'''

定义上面这一段问题的代码:

导入包,输入参数,将DE实例化:(这里三个未知变量X,使用变量维度是3)

这里的run(2000)里面代表的是迭代2千轮,确保收敛。

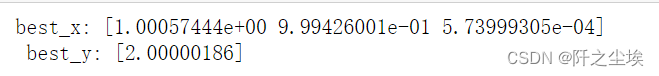

最后的结果:

?这里默认的是寻找最小值,可以看到这个有约束优化问题的最小值为2,当且X1=1,X2=1,X3=0的时候取到。

参数详解

输入参数,很多都是默认好的。其中种群规模,变异概率,变异系数都是差分进化算法里面的参数

| 入参 | 默认值 | 意义 | |

|---|---|---|---|

| func | - | 目标函数 | |

| n_dim | - | 目标函数的维度 | |

| size_pop | 50 | 种群规模 | |

| max_iter | 200 | 最大迭代次数 | |

| prob_mut | 0.001 | 变异概率 | |

| F | 0.5 | 变异系数 | |

| lb | -1 | 每个自变量的最小值 | |

| ub | 1 | 每个自变量的最大值 | |

| constraint_eq | 空元组 | 等式约束 | |

| constraint_ueq | 空元组 | 不等式约束 |

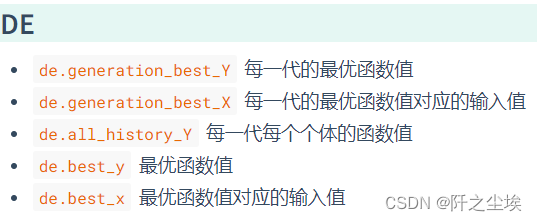

?输出参数:

?这里面的方法都记录了每次迭代的X和y,可以用里面的记录值去画图,展示不同迭代次数时y的变化。

Categories

富联新闻

Contact Us

Contact: 富联娱乐-富联全球导航站

Phone: 13800000000

Tel: 400-123-4567

E-mail: admin@youweb.com

Add: Here is your company address